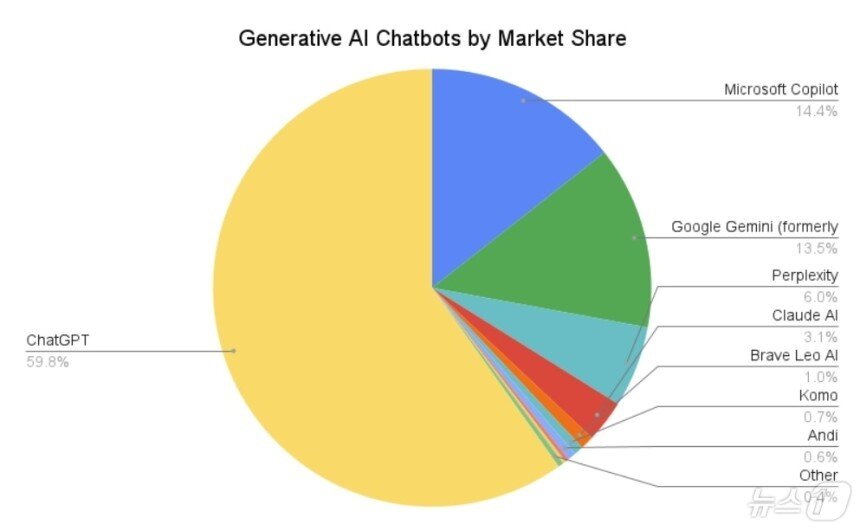

(서울=뉴스1) 김민석 기자 = 중국 '딥시크' 충격 이후 구글·마이크로소프트(MS) 등 글로벌 빅테크 기업들이 저비용·고성능 경량화 인공지능(AI) 모델을 잇따라 내놓으며 그동안 '챗 GPT'가 독식해온 경쟁 구도가 변화하고 있다.

23일 IT 업계에 따르면 최근 구글은 단일 GPU 또는 TPU(텐서처리장치)로 구동할 수 있는 경량 언어모델 '젬마3'를 오픈소스로 공개했다.

젬마3는 '제미나이 2.0' 기술을 기반으로 매개변수를 10억~270억 개 수준으로 크게 줄였음에도 벤치마크 테스트(LM아레나) 결과 △라마-405B △딥시크-V3 △o3-미니 등보다 우수한 성능을 보였다.

구글은 또 '제미나이 2.0 플래시 라이트'를 통해 토큰(AI 모델에서 처리되는 데이터 단위) 100만 개당 0.019달러로 딥시크-V3(0.014달러)에 근접한 비용효율성을 달성했다.

MS는 최근 자체 AI 모델 개발을 가속하며 GPT-4 모델을 대체하려는 움직임을 보이고 있다. 최근 '마이'(MAI)라는 AI 모델군 훈련을 완료하고 자체 AI 도구 '코파일럿'에서 교체 테스트를 진행했다.

이달초엔 소형언어모델(sLM) '파이(Phi)' 시리즈의 최신 버전인 '파이-4-멀티모달'과 '파이-4-미니' 등을 출시했다. 파이-4-미니는 38억 개의 매개변수를 갖춘 텍스트 전용 모델로 딥시크-R1(6710억개)의 0.8% 수준으로 가볍다.

프랑스 미스트랄AI는 '미스트랄 스몰 3.1'(매개변수 24억 개)을 오픈소스로 공개했다.

한국 기업들도 경량화 AI 모델 개발에 박차를 가하고 있다.

LG는 최근 국내 최초 추론 AI 모델인 '엑사원 딥'을 오픈소스로 공개했다. LG는 기본 모델 엑사원 딥-32B(매개변수 320억 개) 경우 딥시크 R1(6710억 개) 대비 5% 규모지만, 동급 경량 모델 기준 성능은 오픈AI 모델 및 딥시크보다 높다고 강조했다.

네이버도 지난달 하이퍼클로바X 소형 모델을 공개하며 기존 대비 약 40% 수준의 파라미터로 운영 비용을 50% 이상 줄였다고 설명했다.

업계는 경량화 모델 개발이 더욱 가속할 것으로 내다봤다. 알고리즘 개선·추론모델 고도화 등 기술이 발전으로 다량의 GPU를 확보하지 않아도 준수한 성능을 확보할 수 있게 돼서다.

단일 GPU·TPU로 작동하는 AI 모델은 모바일·IoT 기기 등 온디바이스 환경에서 AI 모델을 구현할 수 있어 응용 범위 역시 넓어진다.

업계 관계자는 "특정 용도에 맞춰 최적화된 효율적인 경량 AI 모델과 챗GPT처럼 범용적으로 사용할 수 있는 대형 모델이 공존하는 형태로 발전할 전망"이라며 "앞으로도 비용효율성이 AI 모델 선택의 기준이 될 것"이라고 말했다.

ideaed@news1.kr