구글이 진전시킨 양자컴퓨팅, 양자 AI 향해 간다[아무Tech]

- 김승준 기자

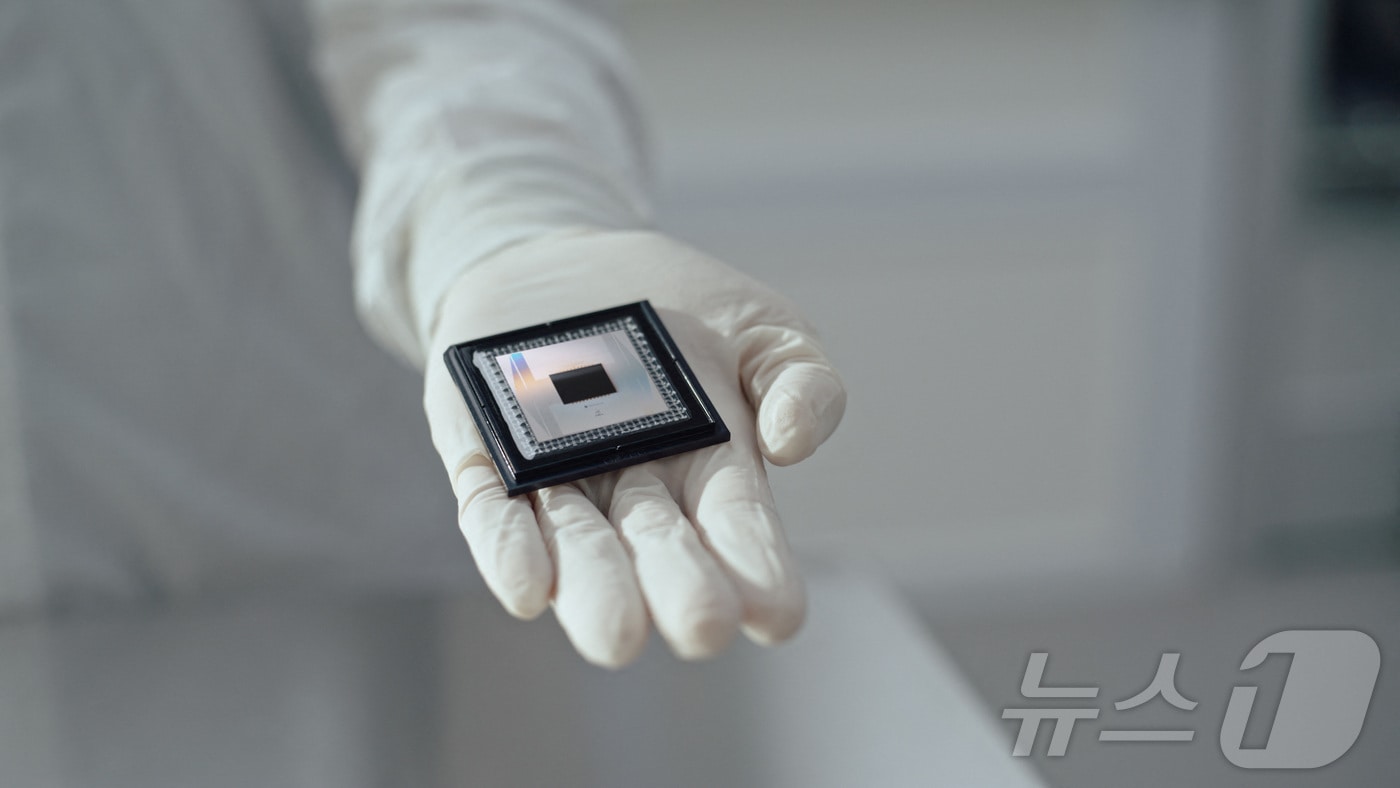

(서울=뉴스1) 김승준 기자 = 구글은 이달 양자 칩 '윌로우'(Willow)를 발표해 기술 업계의 관심을 휩쓸어 모았다.

윌로우는 현재 가장 빠른 슈퍼컴퓨터로 알려진 오크 리지 국립 연구소의 '프런티어'로도 10자 년 걸리는 연산을 5분 만에 풀어냈다. 10자는 10의 25제곱이다.

업계가 윌로우에 주목한 것은 성능뿐 아니라 오류 가능성을 줄였기 때문이다.

현재 양자 컴퓨터는 다양한 방식으로 시도되고 있다. 작은 규모에서 양자 컴퓨팅 구현에 성공한 경우는 많지만 양자 연산 규모를 늘리는 데는 어려움을 겪고 있다.

양자 컴퓨터로 계산할 때의 기본 단위를 큐비트라고 하는 데 큐비트가 늘어날수록 전체 연산 시스템의 양자 상태를 유지하기가 어려워진다.

피어리뷰(동료평가) 전 공개 방식으로 국제학술지 네이처에 발표된 논문에 따르면 윌로우 칩을 이용해 일정 수준 이하로 오류 발생을 억제하는 데 성공했다.

구글은 "윌로우에서 사용하는 큐비트가 많을수록 오류가 줄어들었다"며 "유용하고 매우 큰 양자 컴퓨터를 실제로 구축할 수 있다는 강력한 전조"라고 강조했다.

이번에 개발된 윌로우는 105큐비트 규모며 미국 산타바르바라에 있는 제조시설에서 만들어졌다.

구글은 향후 윌로우 성능을 개선하는 동시에 양자컴퓨터를 활용해 기존 슈퍼컴퓨터로는 할 수 없는 연산이나 알고리즘으로 실용적 문제를 푸는데도 도전할 계획이다.

더 나아가 양자 컴퓨터를 활용한 인공지능(AI)에도 도전한다는 목표도 있다.

하르트무트 네벤 구글 퀀텀 AI 창립자는 "양자컴퓨터를 통해 AI 고도화에서 이점을 얻게 될 것"이라며 "양자 연산은 기존 컴퓨팅 머신에서 접근할 수 없는 학습 데이터를 수집하고 학습 과정을 최적화하는 데 없어서는 안 될 것"이라고 전망했다.

양자 AI는 양자 컴퓨팅과 AI 기술을 결합해 AI 알고리즘의 성능을 획기적으로 향상하려는 시도다. 양자 연산은 디지털 연산에 비해 병렬 연산에 강점이 있다. 이 강점을 살려 데이터 처리, 패턴 인식의 속도와 규모를 높이는 것이다.

양자 AI는 신생 분야인 만큼 양자 머신러닝, 양자 신경망, 양자 강화학습, 양자 최적화, 양자 생성 모델 등 기존 AI 기술과 양자컴퓨팅을 접목하는 다양한 하위 분야가 있다.

예를 들어 양자 머신러닝은 대규모 데이터 분석 학습 알고리즘 개선에 도전하고 있고 양자 최적화는 복잡한 금융, 물류, 공급망 관리 등에서 최적의 결론을 내는 알고리즘 개발 분야다.

다만 이번 구글의 윌로우 칩이 진전을 이뤘지만 실용화를 장담할 수 없다는 회의론도 있다. 구글이 이번에 슈퍼컴퓨터 대비 월등한 성능을 보인 연산은 성능 평가용 연산이며 아직 실용적 계산에 활용하기에는 부족한 큐비트 규모라는 것이다.

또 윌로우는 초전도 방식으로 큐비트를 구현하는 데 현재 기술로는 극저온을 유지하는 냉각 장치가 필요해 규모가 커지는 데 문제가 발생할 수도 있다.

seungjun241@news1.kr

Copyright ⓒ 뉴스1. All rights reserved. 무단 전재 및 재배포, AI학습 이용금지.