"스스로 목적 세우고 행동하는 AI 나오려면 데이터 협력 절실"

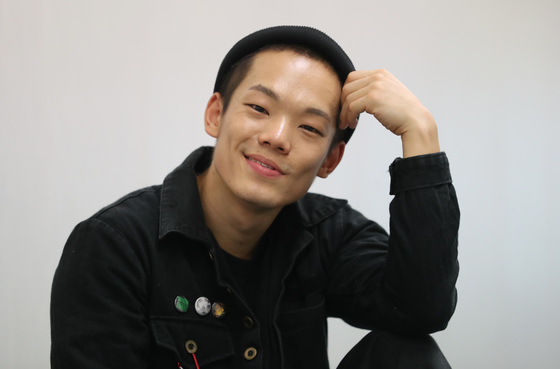

얀 르쿤 "AI가 현실세계 상호작용 기반해 추론할 수 있어야"

"방대한 시청각 데이터 학습 필요…오픈소스 플랫폼 확산해야"

- 윤주영 기자

(서울=뉴스1) 윤주영 기자 = "단순 컴퓨팅 계산이 아닌 물리세상을 직접 관찰하고, 이를 바탕으로 스스로 추론하는 인공지능(AI)이 나와야 한다. 일명 '목적 지향 AI'인데 이것이 메타의 지향점이다"

11일 서울 영등포구 여의도 페어몬트 앰배서더 호텔에서 과학기술정보통신부가 주최한 '2024 K-사이언스 & 테크놀로지 글로벌 포럼'에서 얀 르쿤 뉴욕대 교수는 이같이 강조했다. 그는 메타 수석 인공지능(AI)과학자, 한미 AI 공동연구 플랫폼 '글로벌 AI 프런티어 랩' 초대 공동 소장 등을 지내는 AI 전문가다.

현재 거대언어모델(LLM)은 변호사 시험을 통과하고 시를 창작할 수 있을 만큼 발전했지만, 르쿤 교수는 아직 AI의 실질적 혁명은 오지 않았다고 지적한다.

그는 "열 살 아이도 저녁을 먹으면 알아서 식탁을 치우거나 설거지를 할 수 있지만, 이를 대신해 주는 로봇은 나오지 못했다"며 "인간뿐만 아니라 고양이, 개 등 동물도 초 단위로 자기 행동을 계획할 수 있지만 컴퓨팅으론 이를 구현할 수 없다"고 설명했다.

AI가 단순히 데이터를 수렴해 결과물을 생성해 내는 것을 넘어, 현실 세계와 상호작용하며 스스로 행동을 결정할 수 있어야 한다는 의미다.

한계를 극복하려면 어린이가 세상을 배워가듯이 AI도 현실의 추상적이고 복잡한 시청각 데이터를 관찰·학습해야 한다는 게 그의 분석이다. 여기엔 불완전한 학습 데이터를 AI에 준 뒤 가려진 부분만 추론하게 시키는 훈련이 유효하다고 그는 덧붙였다.

르쿤 교수는 "이는 지난 몇 년간 LLM을 급속도로 발전시킨 훈련방식이었는데, 언어와 달리 동영상은 많은 정보가 중첩돼 있어 결과물을 예측하기 어렵다"고 설명했다.

그에 따르면 이런 훈련을 지속하면 AI도 인간이나 고등 생물처럼 비정형화된 현실 세계를 이해할 수 있을 예정이다. 메타는 올해 이를 골자로 한 새로운 모델 아키텍처 '제파'를 제시하기도 했다.

이런 과업엔 국제사회가 다 같이 데이터를 개방하고 오픈소스를 활성화하는 등 방식의 협력이 필요하다.

그는 "미국 한 지역의 데이터만으론 인류 전체가 실생활에서 누릴 수 있는 AI를 만들 수 없다"며 "공공·민관·클라우드 서비스 사업자(CSP) 및 빅테크가 힘을 모아 강력한 파운데이션 모델을 만들어야 한다"고 강조했다.

이어 "지금까지 인터넷이 발전해 온 것처럼 오픈소스 플랫폼이 확산해야 하고 자원 분배를 통해 컴퓨팅 리소스가 적절히 사용될 수 있어야 한다"며 "규제가 이를 발목 잡는 일이 없도록 해야 할 것"이라고 주문했다.

legomaster@news1.kr

Copyright ⓒ 뉴스1. All rights reserved. 무단 전재 및 재배포, AI학습 이용금지.