딸 흉내낸 '그놈 목소리'…AI 합성으로 드러나 美 '발칵'

SNS에 게재한 영상…AI 음성 학습에 활용될 수도

연방거래위 "손주 전화에 돈 입금해선 안돼" 경고

- 김성식 기자

(서울=뉴스1) 김성식 기자 = 여행을 떠난 딸이 어느 날 울먹이며 "제발 살려달라"고 전화한다면 대다수의 부모는 자녀가 납치됐다고 믿을 수밖에 없다.

그러나 수화기 너머로 자녀의 다급한 목소리가 들리더라도 진위를 꼼꼼히 확인해야 한다. 인공지능(AI)으로 만들어 낸 '가짜 목소리'일 수 있기 때문이다.

12일 AFP 통신은 생성형 AI 기술로 자녀의 목소리를 합성해 부모에게 전화를 건 뒤 몸값을 요구하는 사례가 최근 미국에서 기승을 부리고 있다고 보도했다.

미국 애리조나주에 사는 제니퍼 데스테파노는 최근 지역 방송과의 인터뷰에서 지난 1월 자신의 딸을 사칭한 사기 전화를 받았다고 털어놓았다.

데스테파노는 스키 여행을 떠난 딸이 '살려달라'고 애원하자 "누구인지에 대한 의문은 들지 않았다. 완전히 내 딸아이 목소리였기에 단 1초도 의심하지 않았다"고 회고했다.

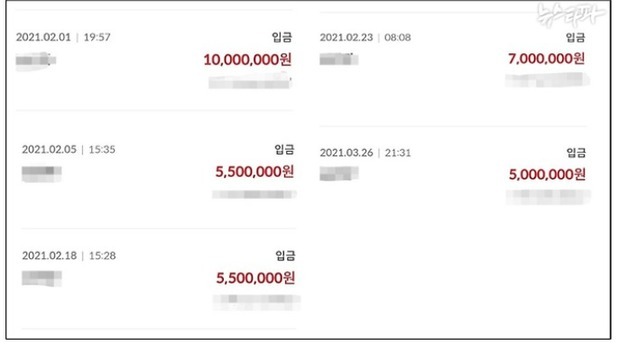

사기범은 이후 낯선 번호로 데스테파노에게 전화를 걸어 100만달러(약 12억원)를 준비하라고 요구했다. 다행히 데스테파노가 몇분 만에 딸과 연락이 닿으면서 상황은 종결됐다. 경찰 조사 결과 딸의 음성은 AI가 합성한 것으로 드러났다.

전문가들은 AI 기술이 사기 행각에도 본격적으로 쓰이기 시작했다며 학부모들에게 자녀의 목소리를 사칭한 사기 전화에 유의할 것을 당부했다.

미국의 디지털보안업체 블랙버드AI의 와심 칼레드 최고경영자(CEO)는 AFP에 "AI의 음성복제 기술은 이제 사람의 말과 거의 구별할 수 없을 정도가 됐다"며 "짧은 오디오 샘플만으로도 AI 합성물을 생성해 음성 메시지 녹음은 물론 실시간 전화 통화도 가능하다"고 말했다.

그러면서 칼레드 CEO는 "사기범들은 성별과 말투, 고유의 억양도 흉내 낼 수 있다"며 AI 음성을 생성할 수 있는 각종 앱이 무료로 유통되고 있다고 지적했다. 또 사회관계망서비스(SNS)에 올려둔 영상이 자칫 AI 음성 학습에 사용될 수 있다고 경고했다.

AI 사기 전화도 최근 증가한 것으로 조사됐다. 보안업체 맥아피연구소가 지난달 발표한 설문조사에서 미국인 응답자 4명 중 1명은 AI에 의한 사기 전화를 받았거나 주변에서 받은 사람을 알고 있다고 답했다. 또 응답자의 70%는 복제된 목소리와 실제 목소리를 구분하기 어렵다고 토로했다.

상황이 이렇다 보니 미 연방거래위원회(FTC)도 지난 3월 대국민 성명을 내고 AI를 활용한 사기 전화를 조심하라고 경고했다. FTC는 "겁에 질린 목소리로 손주가 전화를 걸더라도 절대로 돈을 입금하면 안 된다"며 "AI 음성 복제일 가능성이 있다"고 했다.

seongskim@news1.kr

Copyright ⓒ 뉴스1. All rights reserved. 무단 전재 및 재배포, AI학습 이용금지.